Questo articolo nasce dall’idea di aprire una finestra su quella branca della geomatica che si occupa della condivisione e diffusione in rete dell’informazione geografica, comunemente indicata col termine webmapping e spesso protagonista su questo blog.

Prima di entrare nel vivo del discorso, però, vorrei precisare che quello proposto è il mio personale punto di vista, costruito nel tempo in base alla mia esperienza professionale in questo campo. Esistono altri strumenti e approcci diversi rispetto a quello che vedremo nel corso dell’articolo, quindi, come sempre, ogni commento sarà ben accetto e spunto di ulteriore riflessione.

Sicuramente si parla di una delle specializzazioni dei Sistemi Informativi Geografici che negli ultimi anni si sono trasformate più velocemente, complice l’evoluzione del World Wide Web e delle tecnologie legate ad esso. Si tratta, inoltre, di una materia fortemente interdisciplinare in quanto, a prescindere dall’ambito nel quale l’applicazione di webmapping verrà impiegata (turismo, analisi ambientale, monitoraggi di vario genere, ecc.), a monte ci sono le competenze di almeno quattro figure professionali differenti che comprendono l’esperto di GIS, il Database administrator, lo sviluppatore e il sistemista.

Ho pensato di scrivere un articolo come questo perché spesso mi capita di avere a che fare con persone interessate ad avvicinarsi a questo mondo o semplicemente curiose di sapere “cosa c’è sotto” ma messe in seria difficoltà dalla quantità, eterogeneità e frammentazione delle informazioni disponibili in rete.

Tutto ciò, insieme all’esistenza di una moltitudine di soluzioni software, di tanti standard reali e de facto, di moltissime filosofie e approcci diversi, crea un labirinto intricato in cui è facile smarrirsi specialmente se si è agli inizi.

La cartografia su internet diventa popolare

Un grande contributo all’esplosione della cartografia su internet è arrivato da alcune applicazioni web basate su mappe, come Google Maps, Google Earth, Yahoo! Maps, Virtual Earth (ora noto come Bing Maps), comparse relativamente pochi anni fa e divenute di massa nel giro di pochissimo tempo.

Lungi dall’essere delle applicazioni GIS in senso stretto, hanno comunque il merito di saper mostrare la forza del punto di vista spaziale: ogni oggetto, se collocato nello spazio geografico, viene arricchito con nuove informazioni intrinseche nella sua localizzazione e nella relazione con gli altri oggetti che si trovano nelle sue vicinanze.

La potenza espressiva della cartografia su internet, per la prima volta sotto gli occhi di tutti e non dei soli addetti ai lavori, ha dato un importante input per il cambio di passo che ha condotto alle moderne applicazioni di webmapping.

Certamente questa direzione si è potuta intraprendere anche grazie all’aumento delle capacità di elaborazione dei browser e alla crescita degli strumenti e delle tecnologie per lo sviluppo delle applicazioni web, alcuni dei quali ideati e rilasciati dagli stessi soggetti titolari delle famose mappe online (si pensi, ad esempio, alle API di Google Maps).

Le vecchie cartografie web, oltre ad essere accessibili a pochi, richiedevano spesso tempi di caricamento lunghi o l’installazione di plug-in sulla macchina dell’utente. Le recenti applicazioni di webmapping, invece, beneficiano di uno spiccato livello di interattività e reattività, caratteristiche tipiche delle applicazioni Web 2.0 che sfruttano tecnologie come AJAX e si integrano alla perfezione nell’ecosistema del web moderno, composto da social network, feed RSS e servizi di varia natura.

Standard è bello… e pratico

Una ulteriore spinta alla diffusione di questa nuova generazione di applicazioni di webmapping è venuta dall’affermarsi di standard aperti, documentati e condivisi messi a punto dall’Open Geospatial Consortium (OGC).

Le maggiori case produttrici di software GIS, nonché le comunità open source con i loro innumerevoli progetti, hanno implementato nei loro prodotti il supporto ai principali standard OGC (WMS, WFS, WCS, ecc.) favorendo l’interoperabilità. Chi progetta e sviluppa applicazioni di webmapping oggi ha la possibilità di mescolare risorse disponibili in rete e risorse locali, di utilizzare tecnologie e piattaforme differenti in grado, però, di scambiare informazioni grazie al rispetto degli standard e di ottenere così degli efficacissimi mash-up tramite i quali diffondere l’informazione spaziale.

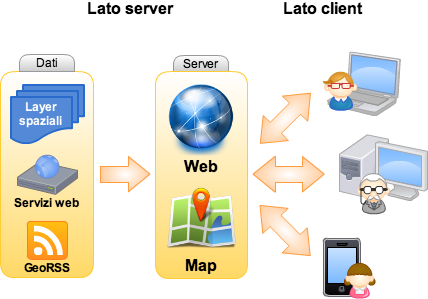

Lato server

A prescindere dai dati, preferibilmente mantenuti in un RDBMS spaziale (come PostGIS o Oracle Spatial), salvo situazioni particolari un’applicazione di webmapping ha generalmente bisogno di due componenti che operano sul server: il web server e il map server.

Il web server, come Apache, solo per citare il più diffuso e più famoso, è l’ambiente che renderà possibile la pubblicazione del lavoro e accoglierà le richieste provenienti dall’applicazione client (quella con cui l’utente interagisce) per passarle al map server. Quest’ultimo, per dirla in maniera molto sintetica, interpreta tali richieste e produce di conseguenza degli output (le mappe) che vengono spedite al client di nuovo attraverso il web server. Ovviamente questo è uno schema generale ed anche se formalmente corretto (ricalca il funzionamento di UMN-MapServer, che è uno dei map server più validi e versatili), occorre tenere presente che ogni software appartenente a questa categoria ha le proprie modalità specifiche di azione. Geoserver ed ArcGIS Server sono altri due ottimi esempi, il primo è gratuito ed open source, come lo è anche UMN-MapServer, mentre l’altro è un prodotto proprietario distribuito da ESRI.

Prima di chiudere la breve panoramica sugli strumenti lato server, è bene ricordare che nel caso delle applicazioni di webmapping più avanzate è necessario avere a disposizione anche un linguaggio di programmazione (Java, PHP, Python, ecc.) per organizzare la logica di business, cioè l’insieme degli algoritmi che gestiscono lo scambio di informazioni tra il client e la banca dati. UMN-Mapserver, ad esempio, è completo di API (Application Programming Interface) per i principali linguaggi di programmazione, mentre ArcGIS Server propone due ADF (Advanced Development Framework) per Java e .Net.

Lato client

Il client, come anticipato nel precedente paragrafo, è quella parte dell’applicazione con cui l’utente finale interagisce. Questo “strato” ha, perciò, un ruolo fondamentale nel decretare il successo o insuccesso dell’intera applicazione. Senza un client efficace che metta in risalto gli strumenti più importanti offerti all’utente e lo prenda quanto più possibile per mano nel compiere le operazioni che lo porteranno ad ottenere la risposta desiderata (un’estrazione di dati tramite interrogazione, l’analisi di una determinata variabile ambientale, ecc.), si rischia seriamente di vanificare gli sforzi profusi nella progettazione e implementazione del database e degli algoritmi lato server.

E’ ovvio che, pur progettando un client ideale, non è sempre possibile raggiungere la massima facilità di utilizzo, poiché tutto è influenzato dal numero delle funzionalità offerte, dalla loro complessità, dal tipo di utenti a cui ci si rivolge e da diversi altri fattori. Tuttavia un’interfaccia utente intuitiva è il risultato a cui si dovrebbe tendere quando si inizia a progettarla.

Come si realizza il client? Le soluzioni sono tantissime, dai template html di UMN-Mapserver, ai framework in PHP come p.Mapper (sempre per UMN-Mapserver) che mettono a disposizione un client con dei moduli dinamici lato server (PHP MapScript), a librerie Javascript come OpenLayers, di cui si è spesso parlato qui su TANTO.

Personalmente preferisco l’ultima soluzione in quanto costruire il proprio client da zero usando una libreria Javascript (OpenLayers non è l’unica), sebbene possa essere inizialmente più laborioso rispetto alla configurazione di un framework come p.Mapper, presenta degli indubbi vantaggi.

Sorvolando sulla valenza didattica del costruire una ad una le funzioni attivate dai vari tasti di una toolbar, ci si rende conto della bontà della scelta quando quello che offre un framework out of the box non basta più e si deve procedere ad un lavoro di personalizzazione/integrazione. Spesso modificare il comportamento di un software complesso, legato ad una specifica piattaforma (UMN-MapServer e PHP MapScript, nel caso di p.Mapper), che comprende numerosi script interconnessi tra loro richiede uno sforzo ben superiore a quello necessario per scrivere da zero una nuova funzione che faccia uso di una classe della libreria OpenLayers (oppure delle API di Google Maps o ArcGIS Server).

Un altro vantaggio – sempre nel caso in cui si scelga di lavorare con Javascript – è che si semplifica di molto l’integrazione nell’interfaccia di librerie per la costruzione di Rich Internet Application (RIA), come jQuery, Dojo, Mootools, YUI o ExtJS, ottime per la creazione di tutti quei piccoli espedienti che rendono il client efficace (nell’accezione usata in precedenza). C’è davvero l’imbarazzo della scelta.

Considerazioni conclusive

Come dicevo in apertura, ci si può discostare anche di molto da quasi tutti gli strumenti elencati e da questo approccio senza per questo sbagliare. Tuttavia nelle prime fasi è utile individuare e chiarire dei concetti specifici, imparare a padroneggiare gli strumenti per muoversi con disinvoltura e poi, in seguito, avventurarsi e testare soluzioni alternative e sempre più originali. In ogni caso alcuni punti, come la creazione di un client intuitivo o il rispetto degli standard, hanno una valenza generale e andrebbero sempre tenuti in debita considerazione a prescindere dalle scelte che si opereranno. Non mi resta che augurare buon divertimento a tutti.

La nostra società nel 2030. Uno studio per indicarci come sarà: se sapremo conquistarcelo. Rubo un titolo, nelle conclusioni si capirà perché.

Ho ricevuto recentemente la segnalazione di questo rapporto: Envisioning Digital Europe 2030: Scenarios for ICT in Future Governance and Policy Modelling. E’ un documento che riporta i risultati della ricerca svolta dall’Unità “Information Society” dell’Institute for Prospective Technological Studies del JRC, lavoro svolto nell’ambito del progetto CROSSROAD, A Participative Roadmap on ICT research on Electronic Governance and Policy Modelling.

“Forse non tutti sanno che…” con Governance and Policy Modelling il Settimo Programma Quadro della Commissione Europea per la R&S nel settore ICT ha voluto sollecitare l’esecuzione di progetti di ricerca in due campi complementari. E’ assai prevedibile –si legge nel Work Programme 2009-2010- che gli strumenti per la collaborazione on-line in futuro consentiranno a una percentuale ampia della popolazione di esprimere simultaneamente opinioni e punti di vista su problemi sociali (grandi o piccoli). Mentre tale scenario è già immaginabile, non esistono ancora modelli di governance, process flows e tool di analisi appropriati per comprendere, interpretare, rappresentare e valorizzare quelle forme di partecipazione collettiva al bene pubblico. Lo sviluppo di strumenti che abbraccino entrambi questi ambiti dell’ICT può contribuire a migliorare il processo decisionale pubblico, far sì che le politiche siano più efficaci, la governance più intelligente, anche grazie alle possibilità di arricchire continuamente le competenze, attraverso un apprendimento continuo nel corso dei processi di applicazione delle politiche stesse.

L’obiettivo generale di CROSSROAD ha riguardato quindi l’identificazione di tecnologie emergenti, di nuovi modelli di governance e di scenari di applicazione innovativi nel campo dell’ICT per la governance e la policy modelling. Gli scopi di questa ricerca sono riferibili all’Agenda digitale per l’Europa, l’iniziativa di punta della strategia UE 2020. Il progetto ha voluto fornire ai decisori politici impegnati nell’attuazione dell’Agenda uno strumento di consultazione, utile anche per contribuire alla definizione di una roadmap della ricerca ICT che vada oltre lo stato dell’arte e sia condivisa dalla comunità dei ricercatori e dalle comunità di pratica.

Per stimolarci a curiosare in un nostro futuro, non lontano, soprattutto su cui possiamo agire, gli autori c’invitano a riflettere, ci ricordano che quanto oggi è realtà poteva sembrare frutto di fantasia quando nasceva internet; di più:

“Se uno avesse previsto poi che, nel 2010, i bambini avrebbero potuto accedere liberamente alle immagini satellitari di ogni luogo della Terra, interagire con persone di tutto il mondo e effettuare ricerche tra trilioni di dati con un semplice click sul loro PC, sarebbe stato preso per pazzo” (pag. 9).

Ecco, di creativa follia mi sembra pervaso questo documento. Esso presenta una visione dell’Europa Digitale tra vent’anni, di una società in cui le Tecnologie per l’Informazione e la Comunicazione a supporto della governance e delle politiche potranno avere un ruolo rilevante e positivo. Evidenzia le principali linee di ricerca nel settore dell’ICT che dovranno essere guardate con attenzione e con quali modalità dovranno essere sviluppate per costruire una Europa Digitale aperta, innovativa e inclusiva nel 2030. Mostra anche come fronteggiare i rischi che potrebbero derivare da un uso improprio dell’ICT in quest’ambito.

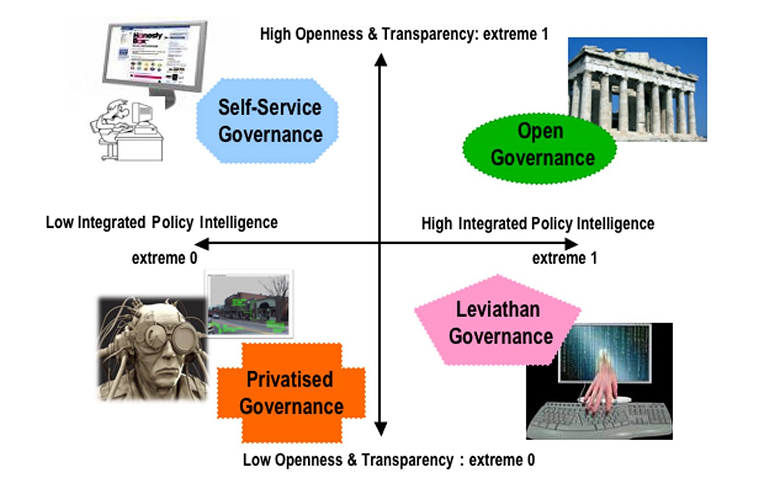

Opportunità e minacce evidenziate attraverso quattro differenti scenari, riguardanti quella che potrà essere la società in cui vivranno i cittadini europei nel 2030, individuati seguendo una rappresentazione schematica rispetto a due variabili, ossia quale potrebbe essere:

- il sistema di valori sociali esistente, vale a dire più inclusivo, aperto e trasparente oppure esclusivo, fratturato e restrittivo,

- la risposta all’impiego delle tecniche di policy intelligence (parziale o completa; proattiva o reattiva), cioè come verranno utilizzati (e da quali soggetti) gli strumenti -abilitati dall’ICT- per l’elaborazione dei dati, la modellazione, la visualizzazione e la simulazione a supporto di strategie politiche pubbliche basate su valutazioni il più possibile razionali e critiche (evidence-based).

I quattro scenari individuati e analizzati in CROSSROAD sono graficamente indicati attraverso gli assi cartesiani del diagramma riportato qui a fianco. Spero di avervi incuriosito e avervi indotto almeno a una rapida lettura del rapporto. Sembrerebbe che lo scenario “Open Governance” sia da preferire, ma anch’esso presenta delle criticità, come riportato nella tabella di pag. 59.

I quattro scenari individuati e analizzati in CROSSROAD sono graficamente indicati attraverso gli assi cartesiani del diagramma riportato qui a fianco. Spero di avervi incuriosito e avervi indotto almeno a una rapida lettura del rapporto. Sembrerebbe che lo scenario “Open Governance” sia da preferire, ma anch’esso presenta delle criticità, come riportato nella tabella di pag. 59.

La società reale europea nel 2030 non corrisponderà quindi a nessuno dei quattro scenari, così come sono stati descritti. Grazie però a questo esercizio, CROSSROAD ha elaborato una visione dell’Europa digitale tra vent’anni, proposta nel documento come una società in cui l’ICT per la governance e la policy modelling potrebbe giocare un ruolo positivo importante.

Penso che il capitolo di maggiore interesse per la Comunità Geomatica possa essere quello conclusivo. E’ la sezione del rapporto in cui, dopo aver chiarito quali saranno le principali problematiche che dovranno essere affrontate nei prossimi vent’anni nell’elaborazione e attuazione delle politiche pubbliche, sono esposti alcuni possibili indirizzi della ricerca nel settore dell’ICT per la governance e la policy modelling: ricerche che siano utili per orientare la società europea verso scenari auspicabili, evitando quelli meno desiderabili.

Un primo ambito dell’ICT su cui indirizzare la ricerca riguarda le tecnologie e le applicazioni per la gestione e l’analisi delle informazioni, per monitorare e simulare in tempo reale il comportamento di entità reali e virtuali (persone, cose, dati e informazioni). Gli autori ci ricordano che alcune compagnie di assicurazioni, avvalendosi di tali tecnologie, propongono ai propri clienti l’installazione a bordo delle auto di apparati che consentono poi di stabilire premi assicurativi basati sul comportamento del guidatore, piuttosto che sulla sua età, o sul suo sesso oppure ancora, la residenza. E’ plausibile -e auspicabile- che soluzioni analoghe siano adottate in altri domini, ad esempio legate alle politiche di assistenza sociale, dei trasporti, dell’energia, o altre ancora. Il settore pubblico potrebbe utilizzare questi strumenti per esaminare scelte differenti, in base al comportamento simulato o all’individuazione dei desideri d’individui, gruppi o della società nel suo insieme. Essi potrebbero quindi aiutare nella comprensione dei possibili risultati delle proposte politiche e dell’attuazione di alternative.

Un secondo campo della ricerca dovrebbe porre l’attenzione sulla crescente fruibilità di dati derivanti dall’enorme uso di sensori miniaturizzati e cablati in strutture fisiche (strade, case, ecc.). Quando tale disponibilità d’informazione sia abbinata a modalità di visualizzazione evolute, essa può avere sui decisori un impatto incredibile sulla percezione tempestiva dell’evoluzione di fenomeni d’interesse. Alcune applicazioni per incrementare la comprensione di situazioni in tempo reale, abbinate a tecniche di visualizzazione dei dati raccolti sono già utilizzate nel campo della logistica, per intervenire sulle rotte di trasporto delle merci, evitare –ad esempio- situazioni di congestione e quindi ridurre i costi di consegna. In conclusione, il rapporto raccomanda lo sviluppo di ricerche che –attraverso queste tecnologie- mirino a sfruttare l’enorme patrimonio di dati e fonti di conoscenze collettive del settore pubblico europeo.

Un terzo filone delle ricerche ICT nel campo della Governance and Policy modelling dovrebbe essere rivolto verso la crescente capacità di internet nel sostenere processi decisionali e pianificatori sempre più complessi e più a lungo termine. Il rapporto evidenzia che a questo fenomeno corrisponde la crescita di requisiti tecnologici connessi alle enormi risorse di archiviazione e elaborazione, associate ai sistemi software evoluti per la visualizzazione grafica delle analisi dei dati. Sono riportati due esempi riguardanti settori in cui queste potenzialità sono materia di ricerca. Il primo si riferisce ai possibili miglioramenti delle attività estrattive degli idrocarburi, grazie all’impiego di vaste reti di sensori, diffuse capillarmente nella crosta terrestre. L’altro pone l’accento sui benefici del monitoraggio dei parametri salienti di malati cronici, mentre questi continuano a condurre la loro vita normale: ciò può consentire ai medici di diagnosticare l’insorgere di situazioni critiche prima che queste s’aggravino.

In tale ambito, definito Policy intelligence and ICT-driven decision analytics, dovrebbero essere promosse ricerche riguardanti il web semantico, così come l’ottimizzazione degli strumenti ICT che agevolino la traduzione automatica, la modellazione dei processi, il data mining, la pattern recognition, le simulazioni basate sulla Teoria dei Giochi, gli strumenti di forecasting e back-casting, le tecniche di ottimizzazione goal-based.

La quarta traccia risultante dallo studio effettuato in CROSSROAD, definita come Automated mass collaboration platforms and real-time opinion visualization, rivolge l’attenzione sugli strumenti e le tecnologie ICT basate ed estrapolate dalla social computing e altre tecnologie future per la collaborazione in rete. Le ricerche in quest’ambito dell’ICT dovranno riguardare -ad esempio- strumenti che consentano di condividere informazioni e conoscenze, superando gli ostacoli dovuti a culture e a lingue diverse. Per favorire la partecipazione dei cittadini ai processi decisionali dovranno essere disponibili strumenti in grado di assicurare la capacità di monitorare l’intero processo del settore pubblico e controllare se, e come, i contributi proposti sono stati poi considerati. Processi che –grazie a queste tecnologie- potranno anche fare riferimento a modelli di governance collaborativi, strutturalmente e organizzativamente innovativi, in grado di consentire a gruppi d’interesse di formarsi, creare e aggregare informazione; imparare e condividere la conoscenza di gruppo accumulata, tenendone traccia. Tale complessità d’interazione tra singoli e gruppi –anche nella realtà virtuale- dovrà essere supportata da strumenti in grado di assicurare la gestione delle identità (anche multiple, pseudonimi, ecc.), la privacy, prevenire frodi, accessi non autorizzati, ecc.: insomma tenere conto dei requisiti necessari perché chi usa questi strumenti avverta fiducia in essi, ma nello stesso tempo sia orientato verso un loro uso responsabile.

Il quinto filone, denominato ICT-enabled data and process optimisation and control, prende spunto dalla possibilità di convertire dati (e analisi sui dati stessi) in istruzioni che -attraverso reti di attuatori- provvedono a modificare i processi. Come i sistemi che regolano i sistemi complessi rendono in molti casi superfluo l’intervento umano, si ipotizza che si possa aumentare l’efficienza e l’efficacia dei processi di governance e dei servizi rilasciati seguendo questa linea di sviluppo dell’ICT. Ciò avverrà ad esempio in maniera sempre più capillare nell’ambito della distribuzione di risorse energetiche o dell’acqua, attraverso l’installazione di contatori “smart” che mostreranno agli utenti in tempo reale l’andamento dei consumi e i relativi costi, consentendo una gestione dei prezzi più dinamica e orientando l’utilizzo consapevole di tali preziose risorse.

Infine, l’ultimo ambito dell’ICT verso cui le ricerche dovrebbero rivolgersi riguarda le applicazioni per la rilevazione di condizioni imprevedibili e l’attuazione di risposte immediate, tramite sistemi automatizzati che riproducono le reazioni umane, anche con livelli di prestazione notevolmente migliori. Tecnologie che si riferiscono a questo campo della ricerca, denominato Complex dynamic societal modelling systems, sono già applicate, ad esempio, dall’’industria automobilistica per lo sviluppo di sistemi in grado di rilevare il pericolo di collisioni imminenti e di evitare l’impatto. Alcune aziende ed enti di ricerca stanno sperimentando “piloti automatici” per i veicoli in rete, guidati in schemi coordinati a velocità autostradale. In altri settori si stanno testando sciami di robot in grado di manutenere strutture o ripulire ambienti da rifiuti tossici. Tutte questi sforzi hanno l’obiettivo di migliorare la sicurezza, ridurre rischi e costi. Mentre leggevo questo documento sono finito qua (giusto per non citare la solita Google car). Il rapporto evidenzia che alcune di queste tecnologie saranno già mature nei prossimi anni e potranno essere quindi utilizzate anche per applicazioni nell’ambito della governance e della creazione delle politiche pubbliche.

Le tecnologie, le discipline e quindi le competenze del mondo ICT coinvolte in questa prima roadmap sono veramente diverse e complesse. Come gli autori precisano, essa non rappresenta neppure un quadro esaustivo: quanto sia vasto il dominio della Governance e Policy Modelling si comprende sfogliando le pagine della sezione “Tassonomia” in Gov2Pedia, prezioso strumento per orientarsi in tale universo.

La lettura di questo rapporto aiuta a scoprire cosa c’è dietro (e anche oltre) la Digital Agenda for Europe. Per esempio, mi ha aiutato a comprendere meglio il commento di David Osimo al recente (15 dicembre scorso) European eGovernment Action Plan 2011-2015 (dalla stessa pagina si può accedere alla versione in italiano), piano per lo sviluppo di servizi digitali per gli europei, secondo concezioni innovative e a supporto della Digital Agenda.

La lettura di questo rapporto aiuta a scoprire cosa c’è dietro (e anche oltre) la Digital Agenda for Europe. Per esempio, mi ha aiutato a comprendere meglio il commento di David Osimo al recente (15 dicembre scorso) European eGovernment Action Plan 2011-2015 (dalla stessa pagina si può accedere alla versione in italiano), piano per lo sviluppo di servizi digitali per gli europei, secondo concezioni innovative e a supporto della Digital Agenda.

Sì, va be’, e la Geographic Information? Non sarà sfuggita un’evocazione leggendo già le prime righe (le immagini satellitari accessibili liberamente anche ai bambini). Nel seguito, l’ho rinvenuta “incorporata” negli applicativi e nei servizi che potranno essere resi disponibili per tutte le aree dell’ICT segnalate come promettenti per la governance e la policy modelling.

Ciò che ora mi piacerebbe leggere, sarebbe un esame del posizionamento della Geoscience rispetto alla visione della Digital Europe nel 2030 proposta in questo documento, un’indagine sui contributi specifici della Geographic Information rispetto agl’indirizzi della ricerca nel settore dell’ICT illustrati nel rapporto. M’interesserebbe anche un approfondimento dei riflessi eventuali di tale visione sugli sviluppi del nostro settore (in risposta a nuovi requisiti, circa aspettative degli utenti, …). Quest’ultimo forse potrebbe essere utile per segnalare ulteriori idee per la ricerca, orientare le strategie per l’implementazione dei servizi, rendere anche più consapevole il nostro lavoro quotidiano.

Nel più recente Programma di Lavoro 2011-2012 del 7° Programma Quadro il tema governance e policy modelling è stato riproposto, sollecitando contributi che aiutino a affrontare “scenari futuri che coinvolgono complessità ancora maggiori e il coinvolgimento dei cittadini, in particolare rispondere alle esigenze delle giovani generazioni”. Può essere un’altra opportunità (il bando si è chiuso lo scorso 18 gennaio) per creare occasioni di dialogo tra il mondo dell’ICT nella sua globalità e il “regno” della GI, i cui confini si stanno dilatando (giusto qui una suggestione per l’urban planning policy, citato nel Work Programme 2011-2012). Potremo comprendere meglio in che modo la Geographic Information sia necessaria per implementare molte soluzioni per tale tema. Ma anche, per il presente, come seguire (e favorire) l’attuazione dell’eGovernment Action Plan anche “nel regno della GI”.

Parafrasando la raccomandazione assai condivisibile di Osimo ai nostri concittadini a Bruxelles “siate ambasciatori delle istanze italiane in Europa e siate disseminatori delle innovazioni europee in Italia”, vale anche un “presentiamo le istanze dell’Informazione Geografica italiane nel contesto dell’Agenda Digitale e siamo disseminatori delle innovazioni digitali nel nostro campo”. Sia in Europa, sia all’interno di una strategia digitale italiana, http://www.agendadigitale.org/.

Il diagramma degli scenari dell’Europa Digitale nel 2030 mi ha ricordato un altro grafico. Lo storico C.M. Cipolla (1922 -2000) nel suo Allegro ma non troppo, proponeva un diagramma per classificare gl’individui in base al loro comportamento. Suggerì di assegnare all’asse delle ascisse la misura dei danni o dei vantaggi che l’individuo procura a sé stesso (vantaggio positivo, danno negativo); mentre indicò che i danni o i vantaggi procurati agli altri fossero assegnati all’asse delle ordinate. Propose di chiamare l’insieme degli individui le cui azioni inducono valori positivi per entrambi tali parametri, come Intelligenti.

Una cosa è discutere tra noi “addetti del settore” (“geek” NdT) di aspetti tecnici, un’altra curare il marketing delle nostre creazioni, delle nostre aziende, e un’altra ancora usare i nuovi media per tendere una mano e aiutare le nuove generazioni.

Queste parole di Jeff Thurston mi hanno letteralmente folgorato quando le ho lette sul suo blog VectorOne. E mi hanno spinto a dire la mia. Stiamo parlando di tecnologie geospaziali, tanto per essere chiari, e del mondo dei media che ruotano loro attorno.

Con Andrea, Massimo e altri (pochi) amici – appunto “addetti ai lavori” – ci confrontiamo spesso su come e dove stia andando la blogosfera geomatica in Italia, e ci chiediamo “a che punto siamo”. Per come la vedo io, in una fase di sostanziale stallo, nella quale il livello della comunicazione sembra non riesca a evolvere verso una comunità nella quale tecnici, tecnologi, utenti, aziende, sviluppatori riescano a costituire una massa critica capace di dare vita a idee, soluzioni tecnologiche, nuovi settori di mercato che siano autenticamente innovativi. E al tempo stesso costruire una base di conoscenze, una risorsa/feedback per la comunità stessa, anche e soprattutto per i “newbie”, coloro che si avvicinano per la prima volta alla geomatica.

Thurston – citando Carlson – evidenzia come il punto debole dei nuovi media su web (in primis i blog) sia l’essere essenzialmente orientati verso la “numerosità dei collegamenti”: più si è linkati, più vuol dire che si è letti, più si è letti, più si è importanti. Un cortocircuito pericoloso che porta al “doping” dell’informazione.

Focalizzando la questione sulla geomatica, sempre citando Thurston

La domanda più importante per la nostra comunità è legata al modo in cui essa si collega allo sviluppo della ricerca, alla formazione, lo studio dell’ingegneria, delle scienze dell’informazione geografica e di tutte le discipline connesse.

[…]

E se i nuovi media siano solamente uno strumento di marketing, o possano essere usati per costruire capacità, supportare altre persone non ancora coinvolte e in che modo poter fare questo. Del resto, nuovi mercati richiedono nuovi clienti.

Clienti, utenti, tecnici, professionisti, studenti consapevoli, aggiungerei io. Si tratta dunque di capire se vogliamo – come attori della comunità geomatica – convergere dalle rispettive posizioni di: aziende votate esclusivamente al marketing, tecnologi e sviluppatori concentrati essenzialmente sulle soluzioni tecnologiche migliori, mondo della ricerca scollegato da quello del mercato, per creare le giuste sinergie che riescano a dar luogo a una massa critica, e un livello dell’informazione costantemente in evoluzione.

Ecco che dunque le aziende illuminate, che producono reale valore aggiunto per la comunità geomatica, sono quelle che promuovono periodicamente concorsi di idee, awards, incentivano la ricerca anche nei singoli, che puntano sull’educazione e sulla formazione nelle scuole. Gli editori, le associazioni più lungimiranti sono quelli che puntano sull’organizzazione di eventi che stimolano l’incontro tra innovatori, mettono a confronto progetti. E per quanto riguarda i media, sempre Thurston:

Qual’è l’equilibrio nella blogosfera geospaziale? Diamo valore alle opinioni e alle differenze di pensiero? O piuttosto cerchiamo l’omologazione orientata al mero conteggio dei link?

Vincente, autenticamente innovativo è l’approccio che porta proprio alla valorizzazione delle differenze dei punti di vista, che mette in discussione lo status quo.

A che punto è la notte, secondo voi, in Italia?

A mio parere i pochi editori “puri” attivi nel settore sono troppo incentrati sul mondo delle imprese, trascurando gli aspetti della ricerca e dell’innovazione. Aspetti che possono invece essere curati e incentivati proprio dalle stesse aziende e rilanciati dalla blogosfera. Quest’ultima ha a sua volta un ruolo fondamentale di stimolo e pungolo sia per il mercato della geomatica, mettendo a confronto le soluzioni tecnologiche commerciali e aperte, sia come punto di riferimento per lo stuolo di nuovi utenti, professionisti e studenti, che sempre più numerosi si avvicinano al nostro mondo, e che chiedono aiuto, orientamento e incoraggiamento.