19 novembre, 2012 | di Sergio Farruggia

-Ciao, come va?-

-Quando son qua bene! -

-E allora vieni più spesso. Cosa fai, sei in pensione?-

-No, lavoro in proprio.-

-Ma che lavoro fai?-

-Uhm, mi occupo di mappe al calcolatore.-

-Bello. Senti, ma ci sono carte militari della zona?-

-Certamente, al 25:000. Anche delle Regioni, forse anche a scale maggiori.-

-Mi piacerebbe andare per funghi con una di queste in mano. Tra M. e P. è tutto un bosco e ci saranno bene sterrate che l’attraversano.-

-Ti cerco che mappe ci sono e ti dico.-

-Ti ringrazio.-

-Buona, vado a prepararmi cena.-

-As vugumma.-

Coincidenze! Ho incontrato Saverio, un amico d’infanzia che vive tutto il giorno all’aria aperta, l’altra sera, quando finalmente mi ero ritagliato il tempo per scrivere questo post, che ha un obiettivo preciso: promuovere una campagna per diffondere l’esistenza e la conoscenza del Repertorio Nazionale dei Dati Territoriali, RNDT.

L’idea l’ho lanciata commentando la presentazione svolta da Gabriele Ciasullo, all’ultima conferenza AM/FM GIS, il 27 settembre scorso. L’ha twittata subito Renzo Carlucci.

L’RNDT è il primo esempio di catalogo dell’informazione geografica digitale in Italia: rappresenta lo strumento per ricercare, attraverso i metadati, i dati territoriali -e relativi servizi- disponibili presso le pubbliche amministrazioni. Consente di valutarne l’idoneità per le proprie esigenze e ottenere le opportune indicazioni sulle loro condizioni di accesso e utilizzo.

Lo strumento è stato formalmente istituito nel 2005 (articolo 59 del Codice dell’Amministrazione Digitale). Trascorsa la fase di progettazione e realizzazione, superata quella di sperimentazione, dai primi mesi del 2012 l’RNDT è in esercizio: l’ultimo rapporto (ottobre) riporta che sono documentati più di duemila dataset e servizi; hanno inserito informazioni tre organi centrali, due autorità di bacino, nove regioni, quattro province e un comune.

L’RNDT, insomma, sta muovendo i primi passi. La finalità della sessione “Il repertorio dei dati territoriali: strumento e motore per l’utilizzo della informazione geografica digitale” organizzata da AM/FM GIS ha avuto proprio lo scopo di presentare le iniziative intraprese sia per sollecitarne il popolamento da parte degli enti pubblici, sia per favorirne l’utilizzo da parte di tutti i soggetti interessati all’Informazione Geografica.

Mentre le istituzioni deputate al popolamento del Repertorio adempiono ai loro doveri (va ricordato lo strumento fa parte delle basi di dati di interesse nazionale, articolo 60 del CAD), anche la comunità geomatica può contribuire al suo sviluppo: aiutando a farlo conoscere, stimolando l’espressione di osservazioni, suggerimenti sull’accessibilità, la fruibilità ecc. dello strumento, anche perché, come si legge sul sito, “Il portale del RNDT è in continua evoluzione”. Vediamola come condizione necessaria, chiaramente non sufficiente, perché il suo popolamento (e il suo continuo aggiornamento) sia stimolato ad accelerare.

Usiamo il logo RNDT sulle nostre homepage e invitiamo a fare altrettanto: blogger, Ordini Professionali, aziende, associazioni, istituzioni… mettiamo l’RNDT nella nostra “cassetta degli strumenti”. Un primo strumento: se l’idea funzionerà potremo aggiungerne certamente altri.

L’informazione geografica digitale rappresenta anche una componente di infrastruttura per le strategie d’implementazione dell’Agenda Digitale italiana e fonte informativa indispensabile per la realizzazione di servizi innovativi nel contesto del paradigma “Smart Cities”. Questa minima azione può essere un piccolo apporto della comunità geomatica, un semplice esempio di come questo modello possa essere interpretato. Facciamo che l’RNDT diventi “l’elenco telefonico” dei dati territoriali italiani.

Chissà, tra non molto tempo anche Saverio, il mio amico d’infanzia che non sta tutto il giorno davanti a uno schermo, saprà che, rivolgendosi all’ufficio comunale o semplicemente chiedendo a qualche compaesano “sempre connesso”, potrà conoscere da chi e come procurarsi una mappa topografica.

TANTO inserisce oggi nella sua homepage il logo (con link) del

Repertorio Nazionale dei Dati Territoriali (RNDT). Attualmente questo strumento sta muovendo i primi passi, ma noi desideriamo che entri a fare parte della “cassetta degli attrezzi” di ogni geomatico e, in prospettiva, di ogni cittadino italiano. Non siamo da soli, ma insieme a:

Posted in Entropia | 8 Comments »

3 maggio, 2010 | di Sergio Farruggia

“I vostri dati fanno schifo” di Pietro Blu Giandonato è caduto a fagiolo proprio mentre stavo riflettendo su come concludere il mio intervento inserito in scaletta al convegno ”La condivisione dei dati geografici in Europa”. Troverete tutte le informazioni riguardanti questa iniziativa sul sito istituzionale del progetto GIS4EU, qui. Da questo indirizzo si può inoltre accedere ai documenti riguardanti l’attività svolta.

Ipotizzo che il lettore interessato sia andato a dare una sbirciatina sul sito ed abbia letto di cosa si è occupato questo progetto. Per i più pigri traduco così: “Proviamo a vedere cosa significa e cosa comporta applicare le regole della direttiva INSPIRE ai dataset esistenti”.

Ciò premesso, posso entrare nel merito dell’argomento che mi era stato affidato, cioè la prospettiva degli utenti sulle SDI: dall’analisi delle esigenze all’utilizzo dei risultati.

In sintesi, si è trattato di esporre i risultati di due analisi effettuate nel corso del progetto. La prima ha riguardato l’individuazione dei bisogni degli utenti di un’Infrastruttura di Dati Territoriali, lavoro svolto nella fase iniziale del progetto. La seconda indagine ha inteso raccogliere informazioni relative all’impatto dei risultati del progetto, coinvolgendo i partner con un ruolo di produttori e fornitori di geodati, ovvero gestori di una SDI.

In sintesi, si è trattato di esporre i risultati di due analisi effettuate nel corso del progetto. La prima ha riguardato l’individuazione dei bisogni degli utenti di un’Infrastruttura di Dati Territoriali, lavoro svolto nella fase iniziale del progetto. La seconda indagine ha inteso raccogliere informazioni relative all’impatto dei risultati del progetto, coinvolgendo i partner con un ruolo di produttori e fornitori di geodati, ovvero gestori di una SDI.

Ho riassunto l’esito di queste indagini nella slide riportata qui a fianco. Per quanto riguarda i bisogni degli utenti di una SDI, oltre alle esigenze di carattere tecnico (requisiti di standardizzazione e armonizzazione dei dati nonché indicazioni per migliorare i servizi di fruizione dei dati stessi) sono emerse esigenze non tecniche, come il miglioramento delle modalità di comunicazione e di dialogo tra data provider e utenti, la riduzione dei vincoli per l’accesso ai dati, il miglioramento della gestione dei metadati, l’aggiornamento più frequente dei dati, politiche di accesso (licenze e prezzi) ai dati minori (in numero) e più chiare. E’ stata anche indicata la necessità di debellare il digital divide esistente all’interno delle pubbliche amministrazioni tra addetti ai lavori e chi ha ruoli di decision maker. Risultato in qualche modo scontato: i limiti segnalati contribuiscono a penalizzare i contenuti di origine pubblica ed il loro impiego per tante applicazioni consumer, ma non solo.

Meno prevedibile il risultato della valutazione che i data provider coinvolti in GIS4EU hanno espresso nei confronti dell’esperienza sviluppata e dei risultati conseguiti. In generale, la metodologia individuata per rendere fruibili i propri dataset secondo le regole INSPIRE è ritenuta adeguata allo scopo. Sussistono sicuramente problematiche legate ai costi della sua applicazione, in particolare, costi da sostenere per la formazione del personale (ad es. per fare propria la complessa documentazione tecnica e mantenersi aggiornati) e per adeguamenti organizzativi: ma è anche ragionevole supporre che questi decresceranno nel tempo, potendo anche immaginare una sempre maggiore diffusione, assimilazione e condivisione delle conoscenze essenziali nel mondo della geomatica. E’ stato certamente incoraggiante –rispetto al punto di vista degli utenti- rilevare che il processo GIS4EU è ritenuto utile per favorire la fruibilità dei dati, soprattutto grazie al miglioramento della compatibilità tra dataset, alla disponibilità di data model ed al salto di qualità nella possibilità di condividere fonti di origine differente. I tecnici interpellati, sollecitati a fornire indicazioni sugli effetti dell’esperienza acquisita secondo diversi aspetti (rispetto alle ricadute operative per le organizzazioni, al valore sociale, a quello strategico e politico), hanno comunque sempre rimarcato –tra i diversi motivi di miglioramento indotti da GIS4EU- la capacità di comunicazione e l’adozione di modalità di collaborazione in rete.

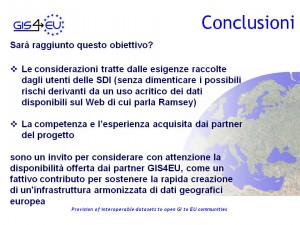

In conclusione: i risultati di GIS4EU possono concorre a soddisfare i bisogni degli utenti delle SDI. Quindi, come evitare che questo risultato si dissolva, come valorizzare l’esperienza acquisita?

E’ stato chiesto ai Data Provider di esprimersi anche riguardo ad una disponibilità per assistere eventuali SDI interessate ad applicare il processo GIS4EU ai propri dataset. L’esito è stato tradotto in termini di “visione”, utile per orientare le persone coinvolte e per comunicare questo proposito anche a progetto terminato.

L’obiettivo dei partner è quello di “Supportare la più attiva ed efficiente cooperazione tra i fornitori di geodataset, gli enti cartografici e altri gestori di dati geografici, nonché per offrire proposte e fornire piani per sostenere la rapida creazione di un’infrastruttura armonizzata di dati geografici europea”.

L’obiettivo dei partner è quello di “Supportare la più attiva ed efficiente cooperazione tra i fornitori di geodataset, gli enti cartografici e altri gestori di dati geografici, nonché per offrire proposte e fornire piani per sostenere la rapida creazione di un’infrastruttura armonizzata di dati geografici europea”.

Ma sarà raggiunto questo obiettivo? Certamente i dati e l’informazione geografica sono di grande interesse, nei più diversi campi, e i produttori di  dati sono un riferimento indispensabile per tanti operatori … e sulla Rete si trovano tanti dati … ma… Ecco, qui Pietro Blu mi è venuto in aiuto: segnala l’avvertimento di Paul Ramsey di OpenGeo recentemente lanciato al congresso Where2.0.

dati sono un riferimento indispensabile per tanti operatori … e sulla Rete si trovano tanti dati … ma… Ecco, qui Pietro Blu mi è venuto in aiuto: segnala l’avvertimento di Paul Ramsey di OpenGeo recentemente lanciato al congresso Where2.0.

Già, crediamo alle mappe e spesso le prendiamo come oro colato. Attraverso di esse produciamo altre informazioni, senza prendere alcuna precauzione. La conclusione di Ramsey è perentoria: “Produttori di dati controllate se e perché i vostri dati ‘fanno schifo’ e ditelo ai vostri utenti”.

L’impegno profuso durante questo biennio da tanti esperti GI, di SDI nazionali, regionali e locali, di diverse nazioni europee può essere raccolto per affermare: “I nostri dati saranno affidabili!”.

Perché prima dell’avvento del computer, il mercato “mapping” aveva caratteristiche affatto differenti ed al prodotto cartaceo si poteva anche perdonare d’invecchiare per anni prima di essere sostituito da una nuova edizione. Non è più così. Ma il mutamento del contesto comporta anche nuovi problemi: Ramsey dixit! Soprattutto: nessun ente cartografico o sistema informativo geografico può ormai lavorare da solo!

Per il settore pubblico questa è un’opportunità da cogliere al volo. Quanto ho imparato partecipando a questo progetto e quanto ho ascoltato dai  relatori dell’incontro genovese va proprio nella direzione che segnalavo di ritorno dalla Global SDI Conference di Rotterdam, l’anno passato: “Le SDI nascono e stanno crescendo più rapidamente, armoniosamente ed hanno maggior successo -cioè soddisfano i bisogni degli utenti (e sono loro a dichiararlo!)- dove è maggiore l’attitudine alla collaborazione, la cooperazione tra istituzioni”.

relatori dell’incontro genovese va proprio nella direzione che segnalavo di ritorno dalla Global SDI Conference di Rotterdam, l’anno passato: “Le SDI nascono e stanno crescendo più rapidamente, armoniosamente ed hanno maggior successo -cioè soddisfano i bisogni degli utenti (e sono loro a dichiararlo!)- dove è maggiore l’attitudine alla collaborazione, la cooperazione tra istituzioni”.

Non si può, non si deve interrompere la strada intrapresa.

Un cammino che dovrà essere percorso insieme: da soggetti pubblici, privati, del mondo della ricerca, come GIS4EU ha dimostrato. Valorizzando le comunità e le aggregazioni di singoli, come stiamo imparando nel word wide web.

D’altro canto –mi son chiesto- perché il direttore di OSGeo si è scatenato con un intervento “a gamba tesa” nell’arena più eterodossa ma anche più creativa della comunità IG internazionale?

Posso sbagliarmi, ma credo che ci sia lo zampino di questa norma: Open Government Directive (OGD, 12/2009). Le parole d’ordine su cui si basa sono: trasparenza, partecipazione e collaborazione (anche in Italia s’inizia a parlarne: a me, per esempio, è piaciuto questo). Mi pare che la “provocazione” di Paul voglia andare a parare lì, come dire: “Il futuro è l’OGD ed io ho la soluzione per aiutarvi ad implementare i suoi principi”. Leggo appunto, visitando il sito di OpenGeo, che propongono una soluzione per aiutare l’implementazione di questi tre principi: “OpenGeo Suite software is standards compliant, fostering collaboration that encourages partnerships and promotes cooperation within the Federal Government, across levels of government, and between governments and private institutions”. Questa è l’evoluzione dell’Open Source: TANTO se n’è interessato qui. Cioè si avvera quanto scriveva T. L. Friedman (Il Mondo è Piatto, Mondadori 2006, pag. 116) soltanto pochi anni fa: “Con il tempo, vedremo emergere un nuovo equilibrio all’interno del quale tutte le differenti forme di software troveranno la propria collocazione: il tradizionale software commerciale, in stile Microsoft o SAP, insieme al modello Business web del software in affitto, in stile Salesforce.com, e al software libero prodotto o da comunità finanziate o da individui ispirati”.

Le SDI saranno conformi ai principi dell’Open Government Directive; formeranno reti cooperative di SDI, sapranno essere aggregatrici di conoscenze e competenze, guarderanno alla tecnologia come contenitore di soluzioni per le proprie esigenze e i propri obiettivi, senza preconcetti “ideologici”, consapevoli della complessità sempre crescente e dei ritmi di obsolescenza a cui sono soggette. E’ per questo che garantiranno dati affidabili.

Posted in News | 4 Comments »

24 ottobre, 2008 | di Pietro Blu Giandonato

Non so quanti di voi abbiano seguito i lavori della O’Reilly Where 2.0 Conference di quest’anno, anche solo virtualmente attraverso i video delle presentazioni. Andrea ne aveva già richiamato l’attenzione in un suo precedente post. Chiunque abbia avuto la fortuna di essere là, avrà respirato aria frizzante, e magari si sara’ chiesto come mai tra i relatori ci fossero figure professionali mosse da filosofie e intenti tanto diverse: società private, ricercatori e professionisti del GeoWeb. Cosa mai si saranno detti? Perché uno sviluppatore di software open-source avrebbe dovuto accettare di parlare dopo un esponente di ESRI o Google? A giudicare dalle presentazioni che mi è capitato di vedere in video streaming, sono domande fuori luogo.

Ciò che mi ha colpito profondamente è invece la grande visionarietà degli interventi. Ognuno di loro era lì per raccontare il proprio sogno, nella convinzione che l’idea della quale avrebbe parlato, avrebbe portato una rivoluzione. Detta così sembra una boutade. E invece no. Si tratta di gente che sa quel che dice.

Di recente A. Turner e B. Forrest hanno scritto Where 2.0: The State of the Geospatial Web, un report che tenta di tirare le somme di quelle giornate. Impresa davvero titanica, e loro ne sono consapevoli. E per questo hanno voluto concentrare la loro attenzione su alcuni concetti chiave venuti fuori dai lavori della conferenza. Il documento è costituito da due parti, nella prima c’è la ciccia, mentre la seconda è una sorta di Pagine Gialle, con un profilo delle aziende e dei soggetti operanti nel settore. I due autori hanno messo a disposizione solo un estratto, le prime 15 pagine, sufficienti comunque a farsi un’idea di quali siano i trend che di qui a qualche anno diverranno il fulcro di tutta la partita che si giocherà attorno al GeoWeb. Io personalmente ho letto solo l’estratto, perchè francamente non mi andava proprio di spendere $400 per acquistare le restanti 40 pagine del report. Comunque, mi piacerebbe discutere di questi trend proprio qui, sia “saccheggiando” che commentando il documento, nella convinzione che siano di interesse per chi cerca di vivere delle cose che ci piacciono TANTO.

Innanzitutto, è importante soffermarsi su un nuovo paradigma sul quale poggiano queste riflessioni, ovvero proprio “Where 2.0“. Alla O’Reilly si riferiscono con questo termine all’emergente Geospatial Web, con un palese riferimento al Web 2.0: internet come piattaforma anche per le applicazioni geografiche. Nel Web 2.0 i dati sono diventati servizi, non più il software. Servizi che letteralmente diventano migliori quanto piu’ vengono utilizzati.

Il futuro sistema operativo, basato su internet, dovrà essere dotato di sottosistemi capaci di attingere a numerose e svariate fonti di dati, e di mescolarle. Questi dati saranno con il tempo quelli piu’ aggiornati, sia da soggetti commerciali che dalle community di volontari e appassionati. Tra questi sottosistemi, il GeoWeb è forse quello maggiormente sviluppato, perché è “multiplayer” e “multilayer”; un melange ricco di dati, servizi e opportunità. Uno dei concetti chiave che è possibile imparare dal GeoWeb, è come i suoi sottosistemi di dati si propongano come mercati aperti quando esiste un substrato, solido e standardizzato, sul quale altri dati possano essere sovrapposti.

Ad esempio il fenomeno dei mashup si è diffuso da quando è stato “hackerato” il sistema di implementazione dei dati di Google Maps. Big G, lungimirante, ha poi immediatamente rilasciato le proprie API aperte (a proposito, qualcuno di voi ha ricevuto la stizzita email del PCN sul “saccheggio” delle ortofoto?). Da quel momento le innumerevoli applicazioni basate su quelle API proliferano in maniera vertiginosa giorno dopo giorno.

E allora? E allora il GeoWeb non può fare a meno di soggetti – privati, pubblici e “open” – capaci di fornire software, dati e IT – ma soprattutto idee e progetti – che per la natura intrinseca del GeoWeb, hanno grandi potenzialità di integrazione tra essi. La sfida per tutti noi che siamo in ballo è dunque quella di trovare la propria dimensione, la propria vocazione nella grande entropia del GeoWeb: sarà la capacità di leggere i trend verso i quali questo complesso universo si muove, che ci permetterà di lavorare al meglio, senza mai sentirsi indietro anni luce rispetto agli altri. La Geografia sarà sempre libera.

Qui di seguito vengono brevemente riportati proprio i trend più interessanti per il GeoWeb – presenti nel report – intesi soprattutto come opportunità per chi opera a vario titolo nel settore. Appare immediata l’enorme dinamicità di alcuni progetti già maturi, come pure le grandi potenzialità di altri ancora in embrione. Colpisce davvero molto proprio questa grande entropia che caratterizza il GeoWeb e tutto ciò che gli ruota intorno.

Merging data colllection with data maintenance.

Nokia ha acquisito la Navteq e TomTom la Tele Atlas; ciò fa capire come i geodati di base – in questo caso i grafi stradali – siano una risorsa fondamentale per applicazioni di geolocation e PND. I costi di manutenzione e aggiornamento di tali dati sono però elevatissimi. E allora sono state messe a punto tecnologie di aggiornamento di tipo attivo e passivo, entrambe coinvolgono gli stessi utilizzatori dei sistemi. TomTom, con MapShare consente agli utenti di segnalare errori nella viabilità, mentre Dash Navigation monitora continuamente i viaggi degli utenti – alla faccia della privacy! – in tal modo statisticamente puo’ individuare i cambiamenti nella viabilità e gli errori nei dati.

Open Data

Il valore propositivo dei dati aperti è il medesimo del software open source: individui e società commerciali contribuiscono al mantenimento del grosso dei dati, cosicché tutti possano beneficiarne. I dati vengono forniti in formati aperti e licenze non proprietarie. Uno dei migliori esempi di progetto che si basa sulla disponibilità di dati aperti e pubblici è GeoNames, che ha costruito un database con i nomi delle località provenienti da fonti di dati pubbliche. Purtroppo l’appetito vien mangiando, e GeoNames sta progressivamente riducendo l’accesso gratuito ai propri servizi, richiestissimi, comunque ampiamente sufficienti alle esigenze dei più.

User generated geospatial information.

Analogamente all’aggiornamento e manutenzione dei dati esistenti di cui s’è parlato prima, gli utilizzatori del GeoWeb possono diventare creatori di nuovi geodati sia in modo passivo che attivo. Al primo caso possiamo ascrivere il servizio di geotagging di foto e video di Flickr. Gli utenti, geoposizionando le proprie foto, e vi associano anche dei tag che quasi sempre sono almeno il nome del luogo. In questo modo si viene a creare un grande database di nomi di luoghi (toponimi?) che puo’ avere un dettaglio anche maggiore dei prodotti “ufficiali”. Un esempio invece di creazione di geodati totalmente nuovi in maniera aperta e comunitaria è il maiuscolo OpenStreetMap. Una sintesi fantastica delle due cose è questa: un’interfaccia di webmapping con alcune foto di Flickr scattate a Pechino, e OpenStreetMap come base cartografica. L’esempio ci fa capire come sia facile mescolare fonti e tecnologie, ma soprattutto quanto siano efficaci progetti aperti di questo tipo (qui per saperne di più). Un progetto molto simile, che integra basi di conoscenze differenti (logs GPS, foto geotaggate) – certamente conosciuto dagli escursionisti non “tecnolesi” – è EveryTrail, grazie al quale è possibile scaricare percorsi trekking con tanto di foto. Ovviamente si tratta di un progetto alimentato in maniera volontaria, su formati di dati aperti (stavolta GPX).

Open*.org

Ma OpenStreetMap è anche di più. Il progetto si è ormai espanso, oltre che come quantità e qualità dei dati anche come tipologia, ed ora oltre a quelli stradali si possono trovare anche dati sull’uso del suolo e addirittura imagery raster, grazie al progetto parallelo OpenAerialMap. Progetti di questo tipo, alimentati in maniera volontaria, basati su OS e con dati non coperti da copyright, hanno fatto comprendere ad alcuni soggetti privati del settore che possono essere una risorsa, anzichè concorrenti. La Automotive Navigation Data, società olandese di PND, ha infatti donato gratuitamente a OSM la propria copertura di dati per l’Olanda e la Cina, la contropartita è ovviamente quella di utilizzare i dai OSM da parte di AND. Innegabili sono infatti le potenzialità di dati liberi generati da comunità di utenti, contro quelli proprietari generati da società private. Un esempio ne è la copertura stradale di Khartoum del progetto OSM (qui) contro quella di Google Maps, con dati NAVTEQ (qui).

L’importanza di essere aperto

Ed è cambiato anche il paradigma legato ai dati con formati aperti e liberi di essere usati. Sebbene qui in Italia sia ancora controversa e difficile la situazione su libero utilizzo e libera distribuzione dei dati detenuti da soggetti pubblici (enti locali, università, ecc), a livello globale l’emergere e affermarsi di standard come KML e GeoRSS obbliga di fatto tutti i soggetti coinvolti a vario titolo nel GeoWeb a concentrarsi ancora una volta sulla ricchezza dei dati e l’architettura dei servizi, piuttosto che sulle scelte tecnologiche e di sviluppo delle applicazioni per poterli usare. Il risultato che ne deriva è una base di conoscenze costruita in maniera condivisa e spontanea, costituita da informazioni non strettamente spaziali, ma che possiedono un valore geografico. Ecco che le foto di Flickr ormai da tempo possono essere geotaggate, come pure i video di Youtube, ed ovviamente essere esportati in KML per venire utilizzati in qualunque applicazione. Un paio di settori in forte espansione sono infatti quello relativo alla conversione di dati da formati proprietari ad aperti – che per le grandi organizzazioni non è uno scherzo affrontare – e il geotagging di documenti e contenuti di qualunque genere, per renderli pronti ad essere utilizzabili nel grande mondo del GeoWeb, in continua, incessante ed inesorabile espansione.

Concludo queste considerazioni sul GeoWeb – fortemente ispirate dal report O’Reilly – ringraziando Andrea, sempre prodigo di consigli e suggerimenti, che mi ha segnalato una delle sue prodigiose scoperte: la presentazione Beyond Google Maps che Mapufacture/Geocommons hanno tenuto al Future of Web Applications FOWA 2008 a Londra. Riesce a sintetizzare con poche parole e molte immagini i concetti dei quali abbiamo discusso qui, dipingendo un futuro davvero entusiasmante per il GeoWeb. Futuro che – in realtà – è già presente…

Godetevela qua sotto, e naturalmente date un’occhiata al report di O’Reilly.

Ultim’ora: Andrea mi segnala che stasera 24 ottobre, alle 18:00 ora italiana, Andrew Turner terrà il webcast “Trends and Technologies in Where 2.0″, assolutamente da non perdere, iscrivetevi, ci vediamo là!

Posted in Dati | 1 Comment »

17 luglio, 2008 | di Pietro Blu Giandonato

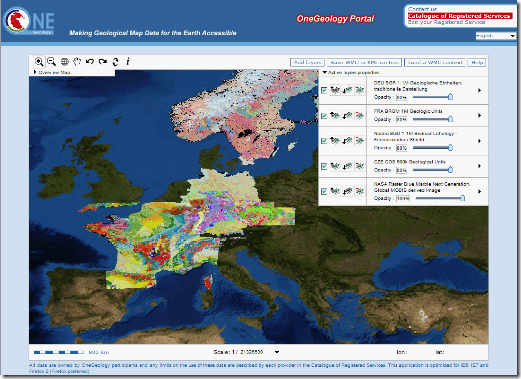

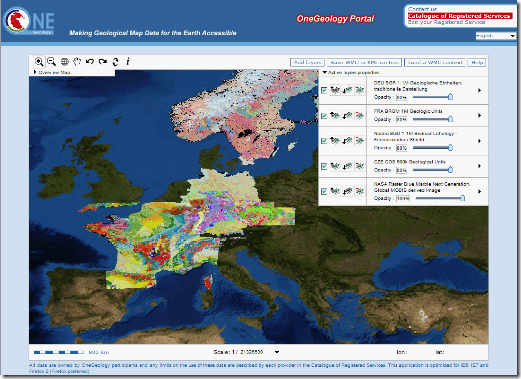

La grande ambizione del progetto OneGeology.org è quella di creare e mettere a disposizione di tutti la grande carta geologica digitale del mondo intero…

Si tratta di un’iniziativa internazionale, promossa dalla rete dei Servizi Geologici di numerosi Paesi, dalle Americhe all’Europa, dall’Africa fino all’Asia. L’Italia è rappresentata dall’Agenzia per i Servizi Tecnici Nazionali (APAT), che anni fa ha fagocitato il glorioso e compianto Servizio Geologico d’Italia.

Ah, giusto per completezza, pare che il nuovo Governo voglia diluire ulteriormente il ruolo dell’APAT accorpandola con l’ICRAM e INFS, per costituire l’Istituto di Ricerca per la Protezione Ambientale (IRPA)… a voi le riflessioni.

Gli obiettivi di OneGeology sono essenzialmente:

- Rendere accessibili le carte geologiche esistenti in qualsiasi formato digitale siano disponibili in ogni Paese.

- Trasferimento di know-how a coloro che ne hanno bisogno, adottando un approccio che riconosca che le diverse nazioni hanno differenti capacità di partecipazione.

- Stimolare un rapido aumento dell’interoperabilità, attraverso lo sviluppo e l’uso del “GeoSciML”, un Geography Markup Language per le geoscienze. Per saperne di più fare clic qui.

Le carte geologiche fornite dai Paesi partecipanti possono essere ammirate grazie al geoportale del progetto, mediante una semplice applicazione webgis che riesce a mosaicare i dataset geologici. E’ possibile esportare le mappe costruite nel geoportale in KML o WMC per poterle ammirare in Google Earth o in altre applicazioni che supportano questi formati.

Insomma… una iniziativa davvero interessante e lungimirante, soprattutto nell’ottica di rendere accessibili in maniera semplice ed aperta dati che altrimenti rimarrebbero disponibili solo ad una stretta cerchia di addetti ai lavori.

Dimenticavo… vi consiglio vivamente di visitare ora e in futuro, perchè in continuo aggiornamento, la sezione OneGeology eXtra con curiosi riferimenti all’influenza che la Geologia ha avuto in numerosi altri campi dello scibile umano (Culture), risorse fantastiche per la didattica (OneGeology4Youngsters) e uno Showcase con i migliori esempi di utilizzo della cartografia geologica digitale…

Up the Geology!!

Posted in News | 4 Comments »

14 aprile, 2008 | di Pietro Blu Giandonato

Uno dei sentieri meno battuti dei dati geografici è quello relativo alla loro comunicazione. E’ davvero difficile, se non impossibile, trovare soluzioni, plugin o applicazioni capaci di tirare fuori prodotti multimediali utili a facilitare la divulgazione di dati spaziali, soprattutto quando la dimensione tempo è fondamentale.

Mostrare efficacemente i trend evolutivi di dati demografici, epidemiologici, ambientali, facendo uso di animazioni è tutt’altra cosa rispetto ad una monotona, fredda sequenza di diapositive di mappe o grafici.

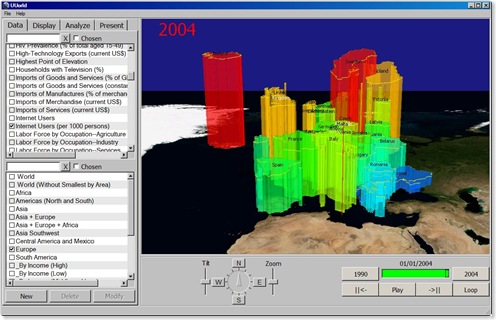

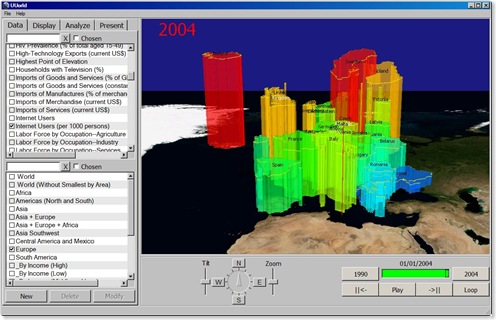

Ed ecco che ci viene in soccorso UUorld, geniale quanto semplice applicazione a metà strada tra GIS e produzione multimediale… in realtà molto più GIS. UUorld è in effetti un viewer di dati geografici con funzionalità estremamente semplici rispetto ai suoi “colleghi”, ma ha un target molto specifico: quello di facilitare e rendere efficace la comunicazione dei dati.

Il punto di forza di UUorld è quello di essere un viewer GIS “4D”, con la possibilità di creare “mappe animate” nelle quali vengono mostrati i trend evolutivi di uno specifico dato, legato ad unità di aggregazione spaziali, come ad esempio le singole nazioni. Così potremo capire ad esempio in che modo si è diffuso l’uso di internet in Europa dal 1990 al 2004, o mettere in evidenza il tasso di analfabetismo a livello mondiale negli ultimi 30 anni.

Una volta selezionato il dato che si vuole analizzare e l’area di riferimento (Europa, Africa, Asia, Americhe o il mondo intero) si potrà scegliere la modalità con la quale visualizzarlo, tra poligoni estrusi che vanno su e giù, gradienti di colore o entrambe. Non resta che inquadrare l’area da visualizzare aggiustando tilt/zoom e cliccare Play, potrete dunque osservare con una efficacissima animazione cosa è successo nel mondo in un determinato periodo di tempo.

Naturalmente è possibile esportare il risultato in diversi formati multimediali, dalla semplice immagine statica al filmato con encoding MPEG-1, MPEG-4, Flash Video e AVI.

L’applicazione è scaricabile ed utilizzabile liberamente, ed è fornita con un set di dati “embedded” di tipo demografico, sociologico, epidemiologico aggregati a livello nazionale, messi insieme dal gruppo di sviluppatori di UUorld. Il dato raster di base usato come riferimento è il classicissimo Blue Marble global mosaic.

Sebbene UUorld sia freeware, è di fatto sviluppato da una software house che basa il suo business sull’assistenza e la consulenza alla realizzazione di applicazioni ad hoc. E il suo limite purtroppo sta proprio in questo. Al momento non è possibile infatti importare dati dall’esterno, e si può solo sperare che questa funzionalità venga presto implementata.

UUorld rimane quindi per ora un bell’applicativo, non customizzabile con dati esterni, ma semplice nell’uso ed efficace nella rappresentazione delle informazioni. Lo vedo particolarmente utile come strumento di analisi delle questioni globali a scuola. Non rimane che sperare il team di sviluppatori sia magnanimo e con le prossime release possa essere possibile importare dati.

Posted in Recensioni | 1 Comment »